Big data platforms

apache spark

La analítica de big data es el uso de técnicas analíticas avanzadas contra conjuntos de big data muy grandes y diversos que incluyen datos estructurados, semiestructurados y no estructurados, de diferentes fuentes y en diferentes tamaños, desde terabytes hasta zettabytes.

¿Qué son exactamente los big data? Puede definirse como conjuntos de datos cuyo tamaño o tipo supera la capacidad de las bases de datos relacionales tradicionales para capturar, gestionar y procesar los datos con baja latencia. Las características de los big data incluyen un alto volumen, una alta velocidad y una gran variedad. Las fuentes de datos se están volviendo más complejas que las de los datos tradicionales porque están siendo impulsadas por la inteligencia artificial (IA), los dispositivos móviles, los medios sociales y el Internet de las cosas (IoT). Por ejemplo, los diferentes tipos de datos proceden de sensores, dispositivos, vídeo/audio, redes, archivos de registro, aplicaciones transaccionales, web y medios sociales, muchos de ellos generados en tiempo real y a muy gran escala.

Con la analítica de big data, puede impulsar una toma de decisiones mejor y más rápida, la modelización y predicción de resultados futuros y la mejora de la inteligencia empresarial. A la hora de crear su solución de big data, considere el software de código abierto como Apache Hadoop, Apache Spark y todo el ecosistema Hadoop como herramientas de procesamiento y almacenamiento de datos rentables y flexibles, diseñadas para manejar el volumen de datos que se genera hoy en día.

biblioteca del núcleo matemático

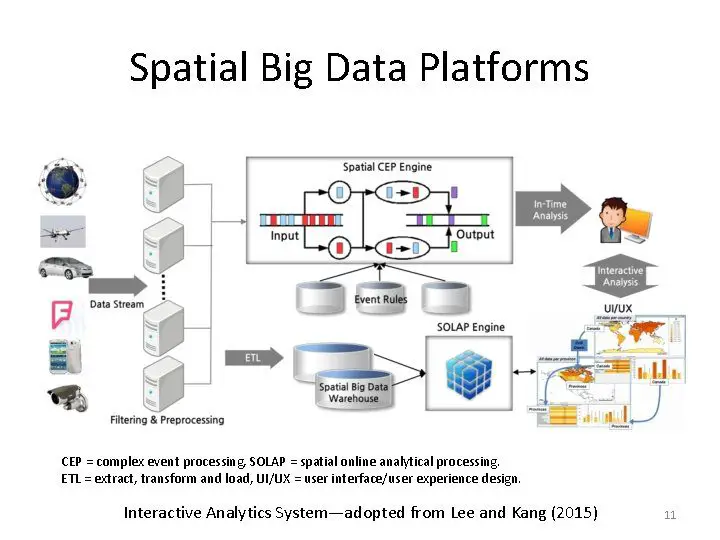

>La plataforma de Big Data se refiere a las soluciones de TI que combinan varias herramientas y utilidades de Big Data en una respuesta empaquetada, y que luego se utiliza para gestionar y analizar Big Data. El énfasis en por qué esto es necesario se trata más adelante en el blog, pero hay que saber cuántos datos se están creando diariamente. Si este Big Data no se mantiene bien, las empresas están destinadas a perder clientes. Empecemos por lo básico.

Esta solución combina todas las capacidades y todas las características de muchas aplicaciones de big data en una única solución. Por lo general, consta de servidores de big data, gestión, almacenamiento, bases de datos, utilidades de gestión e inteligencia empresarial./p>

>También se centra en proporcionar a sus usuarios herramientas de análisis eficientes para conjuntos de datos masivos. Estas plataformas suelen ser utilizadas por los ingenieros de datos para agregar, limpiar y preparar los datos para el análisis empresarial. Los científicos de datos utilizan esta plataforma para descubrir relaciones y patrones en grandes conjuntos de datos utilizando un algoritmo de aprendizaje automático. El usuario de estas plataformas puede crear aplicaciones a medida según su caso de uso, como por ejemplo para calcular la fidelidad de los clientes (caso de usuario de comercio electrónico), y así sucesivamente, hay innumerables casos de uso.

software tableau

ResumenEl objetivo principal de este artículo es proporcionar un análisis en profundidad de las diferentes plataformas disponibles para realizar análisis de big data. Este artículo estudia las diferentes plataformas de hardware disponibles para el análisis de big data y evalúa las ventajas e inconvenientes de cada una de ellas en función de diversas métricas como la escalabilidad, la tasa de E/S de los datos, la tolerancia a fallos, el procesamiento en tiempo real, el tamaño de los datos soportados y el soporte de tareas iterativas. Además del hardware, también se analiza una descripción detallada de los marcos de software utilizados en cada una de estas plataformas, junto con sus ventajas e inconvenientes. Algunas de las características críticas que se describen aquí pueden ayudar a los lectores a tomar una decisión informada sobre la elección correcta de las plataformas en función de sus necesidades computacionales. Utilizando una tabla de clasificación por estrellas, también se discute una rigurosa comparación cualitativa entre diferentes plataformas para cada una de las seis características que son críticas para los algoritmos de análisis de grandes datos. Con el fin de proporcionar más información sobre la eficacia de cada una de las plataformas en el contexto de la analítica de grandes datos, se presentan detalles específicos a nivel de implementación del ampliamente utilizado k-means

corporación oracle

El uso actual del término big data tiende a referirse al uso de la analítica predictiva, la analítica del comportamiento del usuario o algunos otros métodos avanzados de análisis de datos que extraen valor de los big data, y rara vez a un tamaño concreto del conjunto de datos. «Hay pocas dudas de que las cantidades de datos disponibles ahora son realmente grandes, pero esa no es la característica más relevante de este nuevo ecosistema de datos»[4].

El tamaño y el número de conjuntos de datos disponibles han crecido rápidamente a medida que los datos son recogidos por dispositivos como los móviles, los baratos y numerosos dispositivos de detección de información del Internet de las cosas, los aéreos (teledetección), los registros de software, las cámaras, los micrófonos, los lectores de identificación por radiofrecuencia (RFID) y las redes de sensores inalámbricos. [8][9] La capacidad tecnológica per cápita del mundo para almacenar información se ha duplicado aproximadamente cada 40 meses desde la década de 1980;[10] en 2012 [actualización], cada día se generaban 2,5 exabytes (2,5×260 bytes) de datos[11] Según la predicción de un informe de IDC, se preveía que el volumen mundial de datos crecería exponencialmente de 4,4 zettabytes a 44 zettabytes entre 2013 y 2020. Para 2025, IDC predice que habrá 163 zettabytes de datos[12] Una de las cuestiones que se plantean las grandes empresas es determinar quién debe ser el propietario de las iniciativas de big data que afectan a toda la orga